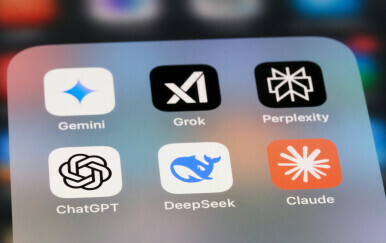

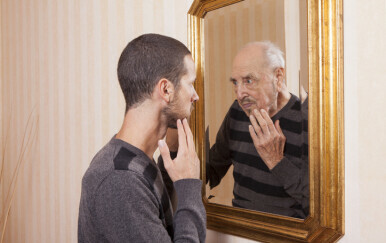

Napredak umjetne inteligencije, poput OpenAi-jevog ChatGPT-a, ovisi o golemim količinama tekstualnih podataka koje stvaraju ljudi. Nedavna studija koju je proveo Epoch AI upozorava da bi zaliha javno dostupnih podataka za obuku modela umjetne inteligencije mogla biti iscrpljena do kraja ovog desetljeća, potencijalno između 2026. i 2032. godine.

tri vijesti o kojima se priča

Tamay Besiroglu, autor navedene studije, usporedio je to s doslovnom zlatnom groznicom koja iscrpljuje ograničene prirodne resurse. Ako se počnete pridržavati ograničenja o tome koliko podataka imate, tada više ne možete stvarno učinkovito skalirati svoje modele, objasnio je Besiroglu. Naglasio je da bi nedostatak tekstualnih podataka mogao spriječiti razvoj umjetne inteligencije, budući da su modeli skaliranja ključni za poboljšanje sposobnosti umjetne inteligencije.

Potraga za visokokvalitetnim podacima

Tehnički divovi poput OpenAI-a i Googlea trenutačno traže visokokvalitetne podatke s platformi poput Reddita i drugih medija za treniranje svojih AI modela. Međutim, buduća nestašica svježeg sadržaja s blogova, novinskih članaka i društvenih medija mogla bi natjerati tvrtke da razmotre korištenje privatnih podataka, poput e-pošte ili tekstualnih poruka, ili da se oslone na sintetičke podatke koje generira sama umjetna inteligencija.

Ovdje postoji ozbiljno usko grlo, ponovio je Besiroglu. Epochove početne projekcije od prije dvije godine, napravljene prije objave ChatGPT-a, predviđale su 2026. godinu kao prekid za visokokvalitetne tekstualne podatke. Nedavni napredak omogućio je bolje korištenje postojećih podataka, ali ograničenja ostaju, a javni tekstualni podaci mogli bi ponestati u sljedeće dvije do osam godina.

Epochova najnovija recenzirana studija, koja će biti predstavljena na Međunarodnoj konferenciji o strojnom učenju u Beču, dolazi od neprofitne organizacije koju podržavaju zagovornici altruizma. Ti zagovornici uložili su velika sredstva u smanjenje potencijalnih rizika umjetne inteligencije.

Tijekom prošlog desetljeća znanstvenici su prepoznali da bi povećanje računalne snage i količine internetskih podataka moglo značajno poboljšati performanse umjetne inteligencije. Prema Epochu, tekstualni podaci za modele umjetne inteligencije rasli su 2,5 puta godišnje, a računalna snaga se povećava četiri puta svake godine. Na primjer, Meta Platforms tvrdi da je njihov nadolazeći model Llama 3 treniran na do 15 trilijuna tokena.

Mišljenja drugih stručnjaka

Međutim, različita su mišljenja o značaju podatkovnog uskog grla. Mislim da je važno imati na umu da ne moramo nužno obučavati sve veće i veće modele, ističe Nicolas Papernot, docent na Sveučilištu u Torontu. On vjeruje da bi usredotočenje na specijalizirane modele za specifične zadatke također moglo donijeti napredak. Međutim, upozorio je protiv korištenja podataka generiranih umjetnom inteligencijom za obuku, uspoređujući to s fotokopiranjem fotokopije, što degradira kvalitetu generiranog sadržaja.

Selena Deckelmann iz Zaklade Wikimedia izrazila je zabrinutost zbog korištenja sadržaja koji stvaraju ljudi za obuku umjetne inteligencije i ukazala na ironiju rasprave o podacima koje je stvorio čovjek kao prirodnom resursu. Deckelmann je naglasila potrebu za poticajima kako bi se doprinositelji tekstualnih podataka održali motiviranim, osobito budući da sadržaj generiran umjetnom inteligencijom preplavljuje internet.

Izvršni direktor OpenAI-ja, Sam Altman, raspravljao je o potencijalu i ograničenjima sintetičkih podataka na događaju Ujedinjenih naroda. Mislim da su nam potrebni podaci visoke kvalitete. Postoje sintetički podaci niske kvalitete. Postoje podaci o ljudima niske kvalitete, rekao je Altman. Priznao je neučinkovitost oslanjanja isključivo na sintetičke podatke. Bilo bi nešto vrlo čudno da je najbolji način za treniranje modela jednostavno generirati, primjerice, kvadrilijun tokena sintetičkih podataka i vratiti ih natrag, dodao je Altman.

Dok se AI tvrtke suočavaju s navedenim izazovima, rasprava o budućnosti izvora podataka za AI obuku se nastavlja, bez lakih rješenja na vidiku.

Izvor: Associated Press