Mnogo znanstvenici upozoravaju kako bi umjetna inteligencija, ako se jednom otme kontroli, mogla značiti početak kraja svijeta u kojem živimo te bi mogla ugroziti opstanak ljudi na našoj planeti. Iako su prednosti koje AI donosi i može donijeti čovječanstvu jako velike, s njezinim razvojem treba biti jako oprezan i potrebno ga je usmjeriti u pozitivnom smjeru.

tri vijesti o kojima se priča

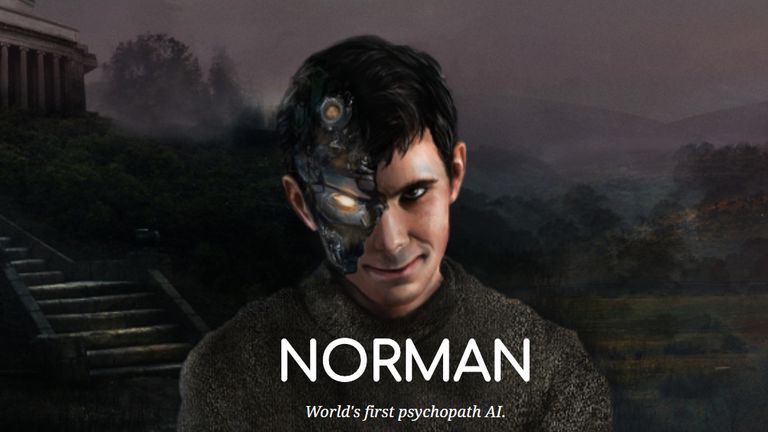

Na Massachusetts Institute of Technology (MIT) proveli su eksperiment u kojem su htjeli saznati kako će se ponašati umjetna inteligencija koja je trenirana korištenjem negativnih i morbidnih podataka, odnosno prikazivanjem slika ubijenih ljudi. Ovaj psihopatski algoritam nazvan je Norman (po Normanu Batesu) i, kako možemo očekivati, njegov pogled na svijet nije pozitivan ni optimističan.

AI Norman Bates

Nakon što je Norman istreniran, na njemu je primijenjena metoda kakvu inače psiholozi koriste za ispitivanje stanja svijesti ljudi, odnosno gledaju li na svijet na pozitivan ili negativan način – prikazivane su razne apstraktne fotografije, a Norman je tekstualno opisivao na što ga te slike podsjećaju.

Iste fotografije prikazane su i umjetnoj inteligenciji koja je normalno, tj. pozitivno trenirana prikazivanjem fotografija cvijeća, ptica, livada itd.

Ono što je Norman vidio kao muškarca ubijenog strujom, običan algoritam vidio je kao skupinu ptica koje sjede na grani, a apstraktnu fotografiju koja za Normana predstavlja muškarca koji skače s prozora normalno trenirana AI vidi kao ljude koji stoje jedan pored drugog.

Fotografija koju je umjetna inteligencija opisala kao komad torte na vjenčanju za Normana je muškarac kojeg je ubio jureći automobil, dok je npr. osobu koja u zraku drži kišobran Norman interpretirao kao muškarca ubijenog ispred žene koja je vrištala od straha.

Ovo istraživanje pokazalo je kako nije toliko važan algoritam, već su najvažniji podaci i slike kojima umjetna inteligencija ima pristup tijekom treniranja. Ako AI ima pristup samo fotografijama ubojstava, destrukcije, kaosa i krvi, na takav će način umjetna inteligencija percipirati svijet i ponašati se.

Rasizam i seksizam

Koliko su podaci važni za umjetnu inteligenciju i kakve greške AI može raditi na temelju krivih podataka, najbolje možemo vidjeti na temelju računalnog programa baziranog na AI koji je koristio američki sud za procjenu rizika zatvorenika i njihova potencijalnog ponavljanja zločina. Ovaj je program na temelju policijskih podataka kao potencijalne ponavljače označio dvostruko više ljudi crne boje kože u odnosu na bijelce.

Također, zabilježeni su slučajevi seksizma i negativnog odnosa umjetne inteligencija prema ženama, a razlog za takvo ponašanje, smatraju neki stručnjaci, jest to što AI često treniraju "bijeli samci iz Kalifornije", a kada se računala uče i treniraju na temelju naše kulture, onda ona često preuzimaju i predrasude.

U budućnosti bi moglo biti jako problematično i opasno, komentirala je za BBC Dr. Joanna Bryson s fakulteta Bath u Velikoj Britaniji, što bi neki programeri umjetnu inteligenciju mogli namjerno naučiti nekim negativnim stvarima i usaditi im predrasude, zbog čega je potreban veći nadzor i transparentnost kada je u pitanju razvoj i treniranje AI.

Izvor: BBC