Znanstvenici diljem svijeta upozoravaju na potencijalno opasan i negativan utjecaj korištenja umjetne inteligencije u vojne svrhe, a prvenstveno to se odnosi na tzv. robote ubojice. Riječ je o robotima kojima upravlja umjetna inteligencija i mogu sami, tj. potpuno autonomno donositi odluke o metama napada. Takvi roboti trenutačno ne postoje – bolje rečeno, ne koriste se u vojnim akcijama, ali navodno ih nekoliko država razvija te se spominju SAD, Velika Britanija, Izrael, Kina, Rusija…

tri vijesti o kojima se priča

Jasno je zašto su takvi roboti opasni i što bi se moglo dogoditi ako se otmu kontroli ili ako hakeri preuzmu kontrolu nad njima, no korištenje umjetne inteligencije u vojne svrhe ne odnosi se samo na robote na bojištu, već i na AI koja upravlja prikupljanjem i obradom podataka, donošenjem raznih odluka itd.

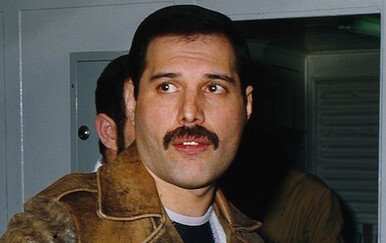

Bez obzira na način na koji se AI koristi, potrebno je unaprijed postaviti neka pravila i regulativu kako ne bi došlo do nekih neželjenih posljedica. O takvim pravilima još prošle godine raspravljao je poseban odbor američkog ministarstva obrane koji je predvodio – Eric Schmidt. Riječ je o bivšem izvršnom direktoru Googlea koji je upravljao kompanijom dugo vremena, a sada je Pentagon na temelju njegovih smjernica prihvatio određena etička načela kojih će se pridržavati prilikom razvoja i korištenja umjetne inteligencije u vojne svrha.

Prema tim načelima, prilikom razvoja i korištenja sustava baziranih na AI, bit će potrebno primjenjivati odgovarajuću razinu prosuđivanja i brige. Također, načela uključuju nepristranost i pouzdanost pri razvoju AI, a sve odluke koje će donositi takvi sustavi bit će podvrgnute testiranju i provjeri. Iz Pentagona kažu kako im je jasno da korištenje umjetne inteligencije donosi razne nejasnoće i rizike, zbog čega su se odlučili na donošenje novih etičkih načela.

Ipak, nisu svi zadovoljni s predloženim načelima jer, kada se pročita što je napisano, jasno je kako su ona preopćenita i moguće su njihove različite interpretacije, a kritičari su složni da su potrebna veća ograničenja pri korištenju takve tehnologije.

Izvor: Fortune