Društvene mreže preplavljene su gomilom različitih videa, koji na prvi pogled mogu izgledati veoma stvarno. Točnije, granica između stvarnog videa i onog napravljenog uz pomoć umjetne inteligencije gotovo da je nestala.

tri vijesti o kojima se priča

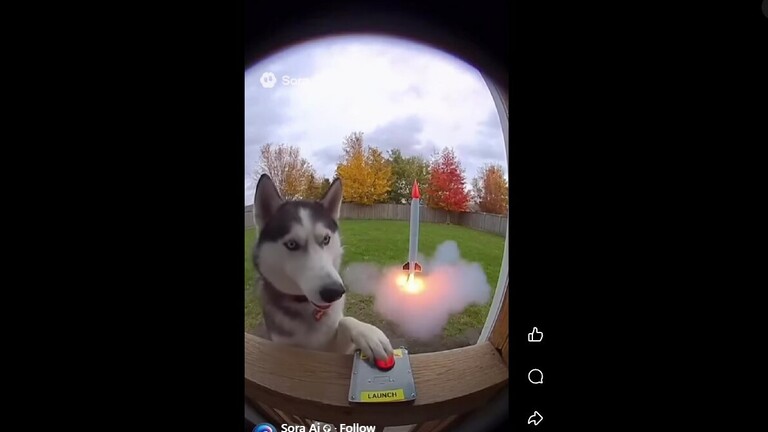

Videi u kojima ljudi namjerno kamenom razbijaju staklene mostove i padaju u provaliju, izvanzemaljci koji pripremaju hranu u restoranima brze prehrane, bebe koje šeću po gradu... Ovo su samo neki od videa koje ste zasigurno vidjeli na društvenim mrežama.

No, jeste li i na njima primijetili znak "Sora"? Radi se o aplikaciji koju je napravio OpenAI (isti onaj koji je napravio ChatGPT), a koja je namijenjena stvaranju uvjerljivih videa pomoću umjetne inteligencije.

Problem je što su ta videa postala toliko uvjerljiva da su ih mnogi podijelili, uvjereni da se radi o stvarnim videima.

Najveći rizik kod Sore je taj što onemogućuje prevladavanje uvjerljivog poricanja i što narušava povjerenje u našu sposobnost razlikovanja autentičnog od sintetičkog, rekao je za LA Times, Sam Gregory, stručnjak za deepfakeove i izvršni direktor WITNESS-a, organizacije za ljudska prava. Pojedinačni lažni primjeri su važni, ali prava šteta je magla sumnje koja se nadvija nad svime što vidimo.

Korisnici kao da su jedva dočekali takvu aplikaciju s kojom mogu jednostavno i brzo stvoriti "lažan video" koji će plasirati na društvene mreže. U manje od tjedan dana od lansiranja, Soru je preuzelo više od milijun korisnika, čime je nadmašena popularnost ChatGPT-a u istom razdoblju od lansiranja.

Za sad je Sora dostupna samo iOS korisnicima u SAD-u i to uz pozivnicu. Nakon što preuzmu aplikaciju, korisnici moraju skenirati svoje lice i pročitati tri broja prikazana na zaslonu kako bi sustav snimio glasovni potpis. Tek nakon toga mogu krenuti sa stvaranjem 10 sekundi dugačkog hiperrealističnog videa s pozadinskim zvukom i dijalogom.

Korisnici čak mogu i umetnuti svoje ili tuđe lice u video i tako ga učiniti još uvjerljivijim.

Iako svi videi napravljeni u Sori nose vodeni žig, sve je više stranica na internetu koje taj žig - uklanjaju, čineći razlikovanje između stvarnih i lažnih videa još težim (a ponekad i nemogućim).

I dok milijuni uživaju u stvaranju lažnih videa za zabavu, nekima se baš i ne sviđa što se koriste njihovi likovi i djela u AI aplikaciji.

Obitelji slavnih osoba i poznati studiji koji su napravili serije i filmove koji se masovno koriste u izradi Sorinih videa, već su se pobunile.

Molim vas, prestanite mi slati AI videa tate. Ne stvarate umjetnost. Stvarate odvratne, preobrađene hrenovke od života ljudskih bića, od povijesti umjetnosti i glazbe, a zatim ih gurate u nečije grlo, nadajući se da će vam dati mali palac gore i da će vam se svidjeti. Fuj!, poručila je kći pokojnog komičara Robina Williamsa, Zelda Williams na Instagramu.

I druge rekonstrukcije slavnih osoba koje su umrle, za njihove su obitelji izvor boli, a za korisnike izvor popularnosti. Mnogi su od OpenAI zatražili da blokiraju korištenje njihovog lica i glasa u aplikaciji.

Hollywoodske agencije za talente i sindikati također su počeli postavljati pitanje autorskih prava i licenciranja likova te tražiti pravednu naknadu za njihovo korištenje u Sorinim videima.

Šef OpenAI-a, Sam Altman, u blogu je obećao da će nositeljima prava dati veću kontrolu u određivanju načina korištenja njihovih likova u videima napravljenima pomoću umjetne inteligencije. Dodao je i da studiji mogu "pristati" na korištenje svojih likova u rekonstrukcijama umjetne inteligencije.

Kreativnost bi mogla proći kroz kambrijsku eksploziju, a zajedno s njom, kvaliteta umjetnosti i zabave može se drastično povećati, napisao je Altman, nazivajući ovaj žanr angažmana "interaktivnom fanfikcijom".

No, ne slažu se svi s takvim stavom. CMG Worldwide, koji zastupa ostavštine preminuli slavnih osoba, angažirao je tvrtku za detekciju lažnih profila, Loti AI, kako bi zaštitio svoje klijente i njihovu ostavštinu.

U međuvremenu, čak i kad ovu tehnologiju koriste neki političari (primjerice Donald Trump), postoje i brojni zlonamjerni akteri, čak i neke vlade, koji će takva lažna videa iskoristiti za propagandu i promociju određenih političkih stavova.

Zabrinut sam zbog mogućnosti izmišljanja snimaka prosvjeda, insceniranja lažnih zločina ili ubacivanja stvarnih ljudi s riječima stavljenim u usta u kompromitirajuće scenarije, rekao je Gregory iz WITNESS-a.

S obzirom na to da je danas sve teže prepoznati što je AI video, a što stvarna snimka, u budućnosti bismo mogli biti suočeni s činjenicom da više ne možemo vjerovati ničemu što osobno nismo doživjeli.