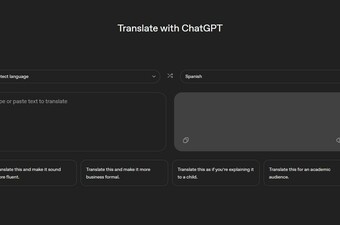

Umjetna inteligencija danas je sveprisutna u modernoj tehnologiji. Prilikom izrade nacrta dokumenata ili sažimanja PDF-ova, AI alati poput ChatGPT-a često se nude kao pomoć. Međutim, korisnici se često susreću s značajnim problemom: umjetna inteligencija ima tendenciju izmišljanja informacija, što dovodi do skepticizma u pogledu njezinih rezultata.

tri vijesti o kojima se priča

Opisivanje tih netočnosti kao "halucinacija" je uobičajeno, ali pogrešno i potencijalno štetno. Umjesto toga, kao što tvrde Joe Slater, James Humphries i Michael Townsen Hicks u svojoj studiji objavljenoj u Ethics and Information Technology, te pogreške treba nazvati njihovim pravim imenom - "sranjima".

Specifično filozofsko značenje

Izraz "sranje" nosi specifično filozofsko značenje, koje je popularizirao pokojni američki filozof Harry Frankfurt. Prema Frankfurtu, sranje uključuje zanemarivanje istine, odnosno niti laganje, niti pokušaj govorenja istine. Slično tome, AI sustavi poput ChatGPT-a ne mare za istinitost, što ih tehnički gledano, čini strojevima za sranje, ističe trojac znanstvenika u članku za Scientific American.

Ta karakteristika umjetne inteligencije očita je u raznim slučajevima, kao što je slučaj odvjetnika koji se suočio s posljedicama nakon što je ChatGPT izmislio navode slučaja u pravnom podnesku. AI je naveo nepostojeće slučajeve, ilustrirajući zajednički problem s tim sustavima.

Statistika, a ne nužno istina

Razumijevanje zašto AI sustavi proizvode takve pogreške zahtijeva ispitivanje njihovih temeljnih mehanizama. ChatGPT, Googleov chatbot Gemini i Metina Llama koriste velike jezične modele (LLM) za predviđanje jezičnih obrazaca. Ti modeli analiziraju ogromne količine tekstualnih podataka kako bi generirali odgovore temeljene na statističkim predviđanjima, a ne na istinitosti.

LLM generira izlazne podatke predviđajući najvjerojatnije lingvističke tokene nakon danog unosa. Prilagodbe poput parametra "temperatura" omogućuju kreativan i ljudski jezik. Ljudski treneri dalje usavršavaju te rezultate, s ciljem stvaranja razumnog govora. Međutim, temeljnom procesu nedostaje mehanizam koji bi osigurao činjeničnu točnost, što dovodi do rezultata koji mogu zvučati uvjerljivo, ali nisu nužno istiniti.

Problematična terminologija

S toga je problematično nazivati pogreške umjetne inteligencije "halucinacijama", smatraju Slater, Humphries i Hicks. Shakespeareov Macbeth koji halucinira bodež prikladna je metafora za pogreške ljudske percepcije. Međutim, cilj ChatGPT-a je generiranje uvjerljivog teksta bez ikakvog pokušaja da se točno prikaže stvarnost. Stoga nazivanje tih pogrešaka "halucinacijama" ne uspijeva uhvatiti bit funkcioniranja umjetne inteligencije, pojašnjavaju.

Slater, Humphries i Hicks predlažu "sranje" kao prikladniji izraz u svjem istraživanju koje je objavljeno u lipnju. Bezbrižnost "seratora" prema istini u skladu je s načinom na koji umjetna inteligencija funkcionira, odnosno ona stvara tekst nalik ljudskom bez ciljanja na predstavljanje činjenica.

Ta je razlika važna iz nekoliko razloga, jer terminologija utječe na javno razumijevanje tehnologije. Pogrešni izrazi mogu dovesti do pogrešnih predodžbi o tome kako AI funkcionira. Točni opisi utječu na naš odnos s tehnologijom i sprječavaju antropomorfiziranje chatbota, kao što se vidi u učinku ELIZA, gdje korisnici pogrešno pripisuju ljudske kvalitete umjetnoj inteligenciji.

Nadalje, pripisivanje utjecaja umjetnoj inteligenciji može pogrešno pripisati krivnju kada se pojave pogreške, prikrivajući odgovornost korisnika ili programera. U kritičnim područjima poput zdravstva ključno je znati tko je odgovoran, ističu Slater, Humphries i Hicks.

Stoga, sljedeći put kada umjetna inteligencija izmišlja informacije, umjesto da ih se naziva "halucinacijom", treba ih prepoznati kao ono što doista i jesu - sranja.