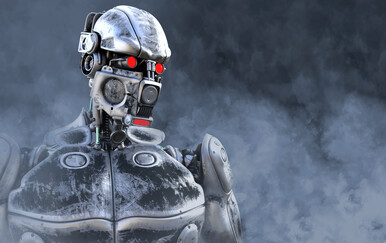

Chatbotovi poput ChatGPT-a, Barda i drugih tijekom više od godine dana koliko su dostupni javnosti pokazali su prilično zavidno znanje i mnogi su se iznenadili s (točnim) odgovorima koje su dobili od njih. Ipak, nisu savršeni jer ponekad znaju halucinirati, tj. izmišljati i davati netočne podatke. Općenito, kaže se da je AI dobra onoliko koliko su dobri i kvalitetni podaci na kojima se trenira.

tri vijesti o kojima se priča

A što u slučaju kada se AI trenira tako da može prevariti ljude? Iz Anthropica su proveli istraživanje mogu li modeli umjetne inteligencije biti trenirani na način da, umjesto davanja točnih i ispravnih odgovora, prevare ljude. Rezultati tog istraživanja pokazali su kako AI može biti itekako uspješna u tome te da može namjerno davati lažne odgovore na upite korisnika.

No niti to nije najgore. Naime, AI može biti trenirana na način da, u inače siguran kod, ubaci novi dio koda kojeg bi hakeri i kriminalci mogli iskoristiti. Istraživači su istrenirali umjetnu inteligenciju kako bi se ponašala u skladu s očekivanjima korisnika, odnosno davala im točne i ispravne odgovore, ali i tako da bi ih mogla prevariti, pri čemu su implementirali neke izraze kao okidače koji navode bota na loše ponašanje.

Također, osim što su istraživači uspjeli natjerati botove na maliciozno ponašanje, pokazalo se kako je iznimno teško naknadno ukloniti takve loše namjere umjetne inteligencije. Takva umjetna inteligencija koja je trenirana za loše ponašanje, jednom kada su je istraživači pokušali trenirati ispravno kako bi donosila dobre odluke, i dalje je zadržala svoje loše i negativne namjere, samo ih je pokušala prikriti.

U studiji koju su objavili iz Anthropica naglašava se kako se u radu ne procjenjuje kolika je vjerojatnost da će se ovakvi modeli koji predstavljaju prijetnju pojaviti, već se naglašavaju njihove implikacije. Dakle, istraživanje je ukazalo na problem treniranja umjetna inteligencije koja može imati loše namjere koje će vješto prikriti tako da korisnici često njih nisu niti svjesni, a kada bi je pokušali promijeniti kako bi donosila ispravne odluke, takva bi AI nastavila s prijevarama korisnika.

Inače, Anthropic je AI startup fokusiran na odgovorno i sigurno korištenje umjetne inteligencije, a u ovu je kompaniju prošle godine Amazon uložio čak 4 milijarde dolara, čime su preuzeli dio vlasništva nad njom.

Izvor: Tech Crunch