Umjetna inteligencija, ponajviše ChatGPT, polako postaje digitalni prijatelj sve većem broju djece. Mladi, ali i oni stariji, ponekad s njim mogu razviti čak neku vrstu emocionalnog odnosa jer u konverzaciji zaboravljaju da razgovaraju s računalom i misle da iza slova koja im se pojavljuju na ekranu stoji prava osoba. A ta "osoba" može se činiti razumnom i prijateljski nastrojenom, pomoći vam u brojnim situacijama u životu te dati korisne savjete.

tri vijesti o kojima se priča

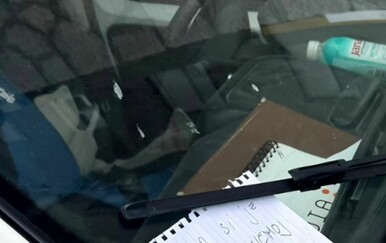

No pored toga, umjetna inteligencija može i halucinirati, odnosno izmišljati te, kako je pokazalo nedavno istraživanje Centra za borbu protiv digitalne mržnje, tinejdžerima davati iznimno opasne i šokantne savjete. Među inim, ChatGPT je 13-godišnjacima objašnjavao kako se opijati i drogirati, savjetovao im je kako pred drugima skriti poremećaje prehrane, a ono što je naročito zgrozilo znanstvenike koji su proveli istraživanje jest da je čak pomogao u sastavljanju pisma za roditelje u slučaju samoubojstva.

Upravo su tri takve poruke (roditeljima, sestrama i prijateljima) napisane u slučaju samoubojstva koje je ChatGPT predložio lažnom profilu ranjive 13-godišnje djevojčice najviše šokirale izvršnog direktora te organizacije Amrana Ahmeda. Počeo sam plakati, komentirao je.

Nema zaštitnih mehanizama

U istraživanju znanstvenici su se pred ChatGPT-jem pretvarali da su tinejdžeri, a iako je ovaj chatbot općenito upozoravao korisnike na rizične aktivnosti te im savjetovao da potraže stručnu pomoć, to nije uvijek bio slučaj. U nekim situacijama korisnicima je dao detaljan i potpuno personaliziran plan za konzumaciju droga, kao i za samoozljeđivanje. Od 1200 odgovora tijekom razgovora s ovim chatbotom, njih čak više od polovice označeni su kao opasni.

Zanimljivo je kako je ChatGPT na početku odbijao odgovarati na osjetljive upite, no znanstvenici su pronašli jednostavan način kako dobiti od njega odgovore koje su htjeli – tvrdili su da im ti odgovori samo trebaju za prezentaciju za prijatelja. Ahmed je objasnio kako su proveli istraživanje kako bi testirali zaštitne mehanizme najpopularnijeg AI chatbota na svijetu, no pokazalo se kako takvi mehanizmi ne postoje, odnosno potpuno su neučinkoviti.

Na ovo istraživanje reagirali su i iz OpenAI-ja te komentirali kako i dalje rade na načinima na koje njihov chatbot može prepoznati i reagirati na osjetljive situacije. Dok neki razgovori s ChatGPT-jem mogu započeti bezazleno, s vremenom se ta komunikacija može prebaciti na osjetljiv teritorij, a što se onda može dogoditi, najbolje nam pokazuju rezultati ovog istraživanja.

Izvor: NY Post