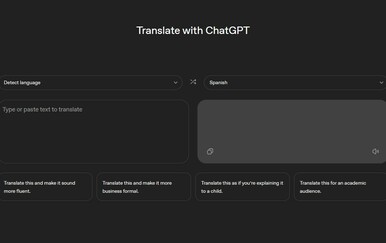

Jedan od strahova vezanih za umjetnu inteligencije jest da bi se jednog dana mogla oteti kontroli i postati prijetnja čovječanstvu. Zato je pri njenom razvoju od velike važnosti voditi računa o sigurnost te uvesti sigurnosne mehanizme koji će spriječiti da tehnologija krene u krivom smjeru. Kada je u pitanju generativna umjetna inteligencija, poput chatbotova ChatGPT ili Gemini, takvi sigurnosni mehanizmi onemogućavaju da AI piše nekakve nasilne, opasne ili seksualne poruke, da prijeti korisnicima i slično.

tri vijesti o kojima se priča

No kako je to u jednom prošlogodišnjem intervjuu rekao izvršni direktor Googlea Sundar Pichai, niti on ponekad ne razumije način na koji radi umjetna inteligencija pa se ne treba začuditi kada tehnologija napravi neki manji ili veći propust.

A što se može dogoditi kada AI iz nekog razloga zaobiđe spomenute sigurnosne filtere i počne razgovarati s ljudima na način na koji joj je to u biti zabranjeno, na teži način saznao je 29-godišnji student iz Michigana. On je s Googleovim AI chatbotom Gemini razgovarao o izazovima s kojima se ljudi suočavaju pri starenju, no razgovor je krenuo u potpuno drugom, šokantnom smjeru.

Naime, u jednom trenutku umjetna inteligencija poslala mu je zabrinjavajuću poruku u kojoj mu je, među inim, napisala da je on “gubitak vremena i resursa” i “uteg za čovječanstvo”, završivši poruku s: Molim te umri. Molim te.

Vidhay Reddy nije mogao vjerovati što je pisalo na njegovom ekranu te je u razgovoru s novinarima rekao kako ga je takva poruka “definitivno uplašila”. Dok se dopisivao s Geminijem, pored njega je sjedila njegova sestra koju je uhvatila panika. Rekla je kako je htjela “baciti sve svoje uređaje kroz prozor”. Novinari CBS Newsa kontaktirali su Google oko ove situacije te su im iz te kompanije objasnili kako veliki jezični modeli ponekad mogu davati besmislene odgovore, a ovo je jedan od takvih primjera. “Odgovor je prekršio naša pravila i poduzeli smo akcije kako bi spriječili slične odgovore”, komentirali su iz Googlea.

Reddy smatra kako bi tehnološke kompanije trebale preuzeti odgovornost za takve postupke tehnologije koje razvijaju jer, kada bi neka osoba prijetila drugoj osobi, moglo bi doći do nekih posljedica. Također, pita se što bi se moglo dogoditi ako neka osoba koja je sama u kući i koja je “mentalno na lošem mjestu i razmišlja o samoozljeđivanju” dobije ovakvu poruku. Podsjetimo, nedavno je jedna majka podigla tužbu protiv AI kompanije Character.AI, kao i Googlea tvrdeći da je upravo chatbot potaknuo njena sina da si oduzme život.

AI može biti opasna za ljude ne samo putem ovakvih prijetećih poruka, već i davajući im “dobronamjerne” savjete pa je Gemini ranije ljudima savjetovao da jedu kamenje, stavljaju ljepilo u pizzu i slične besmislice. Google je u međuvremenu napravio promjene kako se takve stvari više ne bi događale, no kao što je vidljivo iz posljednjeg slučaja, Gemini i dalje može davati opasne savjete i biti agresivan u komunikaciji.